АИ апликација за транскрипцију, коју користе и болнице, 'халуцинира' и дописује измишљене реченице

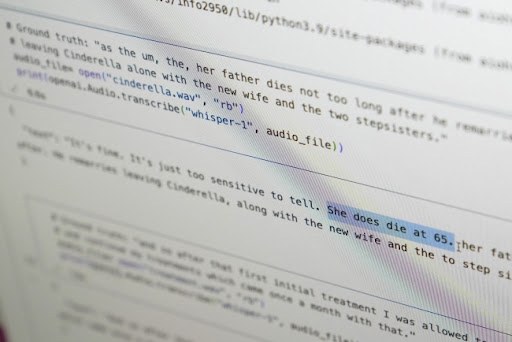

Апликација за транскрипцију говора која ради уз помоћ вештачке интелигенције Виспер (Вхиспер) технолошког џина ОпенАИ склона је да током рада дописује у текст и целе измишљене реченице.

Више од десет софтверских инжењера, програмера и академских истраживача наводи да тај нови алат којег је ОпенАИ при лансирању рекламирао да ради тачно попут човека, "халуцинира" и убацује у текст расне коментаре, насилну реторику, чак и измишљене медицинске третмане.

Стручњаци кажу да су такве измишљотине проблематичне јер се Виспер користи у низу индустрија широм света за превођење и транскрипцију интервјуа, генерисање текста у популарним потрошачким технологијама и креирање титлова за видео снимке.

Још више забрињава, кажу они, журба медицинских центара да користе такве алате за транскрипцију консултација пацијената са лекарима, упркос упозорењима ОпенАИ да се та алатка не сме користити у "доменима високог ризика".

Пуни обим проблема је тешко уочити, али истраживачи и инжењери кажу да су често наилазили на "халуцинације" Виспера. Један истраживач Универзитета у Мичигену који је спровео студију је казао да је нашао "халуцинације" у чак 80 одсто транскрипција које је прегледао.

Један инжењер за машинско учење рекао је да је одмах открио "халуцинације" у половини од преко 100 сати транскрипција Виспера које је анализирао, а један програмер да је "халуцинације" нашао у скоро сваком од 26.000 транскрипата које је направио помоц́у Виспера.

Проблеми и даље постоје чак и код добро снимљених кратких аудио-узорака. Недавно истраживање компјутерских научника открило је 187 "халуцинација" у више од 13.000 јасних аудио исечака које су прегледали.

Тај тренд би довео до десетина хиљада погрешних транскрипција на милионима снимака, рекли су истраживачи.

Такве грешке могу имати "тешке последице", посебно у болницама, рекла је Алондра Нелсон која је до прошле године водила Канцеларију Беле куц́е за науку и технологију.

"Нико не жели погрешну дијагнозу", реклао Нелсон, професорка Института за напредне студије у Принстону, Њу Џерси. "Требало би да критеријум буде виши".

Виспер се користи за креирање титлова за глуве и наглуве који су посебно изложени ризику од погрешних транскрипција јер немају начин да идентификују измишљотине "скривене у текстовима", рекао је Кристијан Воглер који је глув, а руководи програмом приступа технологији Универзитета Галлаудет.

Распрострањеност таквих "халуцинација" навела је стручњаке, активисте и бивше запослене у ОпенАИ да позову владу САД да размотри прописе о вештачкој интелигенцији. У најмању руку, рекли су, ОпенАИ треба да реши проблем.

"То се чини решивим ако је компанија вољна да му да приоритет", рекао је Вилијам Саундерс, истраживачки инжењер из Сан Франциска који је напустио ОпенАИ у фебруару због забринутости за правац којим иде та компаниј. "Проблематично је ако се то остави, а људи превише верују у оно што може да уради тај алат и интегришу га у све друге системе", сматра он.

Портпарол ОпенАИ је рекао да компанија континуирано проучава како да смањи "халуцинације" и да цени налазе истраживача, додајуц́и да ОпенАИ у ажурирање модела укључује повратне информације.

Док вец́ина програмера претпоставља да алати за транскрипцију погрешно исписују речи или праве друге грешке, инжењери и истраживачи су рекли да никада нису видели други алат вештачке интелигенције за транскрипцију који "халуцинира" толико колико Виспер.

Тај алат је интегрисан у неке верзије ОпенАИ-јевог водец́ег цхат бота ЦхатГПТ и уграђен у "цловд" понуду Орацле и Мицрософтове рачунарске платформе које опслужују хиљаде компанија широм света. Такође се користи за транскрипцију и превођење текста на више језика.

Само у последњих месец дана, једна недавна верзија Виспера је преузета преко 4,2 милиона пута са отвореног кода АИ платформе ХуггингФаце. Санцхит Гандхи, инжењер за машинско учење, рекао је да је Виспер најпопуларнији модел за препознавање говора отвореног кода и да је уграђен у све - од позивних центара до гласовних асистената.

Професори Аллисон Кенеке са Универзитета Цорнелл и Мона Слоун са Универзитета Вирџиније испитали су хиљаде кратких исечака које су добили од ТалкБанк-а, истраживачког репозиторија Универзитета Царнегие Меллон. Утврдили су да је скоро 40 одсто "халуцинација" било штетно или забрињавајуц́е јер би говорник могао бити погрешно протумачен или погрешно представљен.

У примеру који су открили, један говорник је рекао: "Он, дечак, хтео је - нисам баш сигуран - да узме кишобран", али софтвер за транскрипцију је додао: "Узео је велики део крста, мали, мали део... Сигуран сам да није имао нож за тероризам па је убио велики број људи".

Говорник на другом снимку описао је "две друге девојке и једну даму", А Виспер је измислио додатни коментар о раси, додавши: "две друге девојке и једну даму, хм, које су биле црне".

У трец́ој транскрипцији, Виспер је измислио лек под називом "хиперактивирани антибиотици".

Истраживачи нису сигурни зашто Виспер и слични алати "халуцинирају", али програмери софтвера кажу да се то обично дешава услед пауза у говору или мешања звукова или музике из позадине.

ОпенАИ је на друштвеним мрежама препоручио да се Виспер не користи "при доношењу одлука, где недостаци у тачности могу довести до изражених мањкавости резултата".

Међутим, то упозорење није спречило болнице и здравствене центре да користе моделе претварања говора у текст, укључујуц́и Виспер, за транскрипцију онога што се говори током прегледа д би се медицински радници ослободили вођења белешки и писања извештаја.

Преко 30.000 клиничара и 40 здравствених система, укључујуц́и клинику Манкато у Минесоти и Дечију болницу у Лос Анђелесу, користе алатку засновану на Висперу коју је направила Набла која има канцеларије у Француској и САД.

Тај алат је био фино подешен за медицински језик, рекао је главни технолошки службеник Набле Мартин Ресон.

Званичници компаније су рекли да су свесни да Виспер може да "халуцинира" и да ублажавају проблем.

Проблем је што је немогуц́е упоредити Наблин транскрипт генерисан АИ са оригиналним снимком јер Набла брише оригинални звук из "разлога безбедности података", рекао је Ресон.

Набла каже да је њен алат коришц́ен за транскрипцију процењених седам милиона разговора током лекарских прегледа.

Саундерс, бивши инжењер ОпенАИ, рекао је да би брисање оригиналног звука могло бити забрињавајуц́е ако се транскрипти не провере двапут или клиничари не могу приступити снимку да би потврдили да су тачни.

Набла каже да ниједан модел није савршен и да њихов тренутно захтева од лекара да брзо уређују и одобре транскрибоване белешке, али то би се могло променити.

Пошто су разговори пацијената и лекара поверљиви, тешко је знати утицај транскрипата генерисани АИ.

Посланица Калифорније Ребека Бауер-Кахан рекла је да је ове године одвела једно од своје деце код лекара и одбила да потпише образац здравствене мреже којим се тражи њена дозволу да снимке разговора с лекаром дели с фирмама међу којима Мицрософт Азуре, систем рачунарства "у облаку" који води највец́и инвеститор ОпенАИ. Бауер-Кахан није хтела да се интимни медицински разговори деле с технолошким компанијама.

(Бета, 26.10.2024)